Utilice las imágenes infrarrojas de tiempo de vuelo para mejorar las capacidades robóticas.

Colaboración de Editores de DigiKey de América del Norte

2016-05-19

Las imágenes son fundamentales para numerosas aplicaciones robóticas y les permiten realizar tareas básicas, evitar obstáculos, navegar y garantizar una seguridad básica. La manera obvia de brindar imágenes es mediante una cámara de video de bajo costo o, mejor todavía, mediante la utilización de dos cámaras para la percepción de la visión y de la profundidad. Sin embargo, la última opción presenta ciertas desventajas.

La utilización de cámaras duales para las imágenes 3D aumenta el consumo de energía y los requisitos de espacio a la vez que complica el factor de forma, el proceso de fabricación y aumenta los costos. Dado que las imágenes en 3D se estandarizan en aplicaciones que abarcan desde unidades básicas de “asistencia” hasta vehículos autónomos, los diseñadores requieren una mejor alternativa que no consista simplemente en sumar más cámaras.

Para lograrlo, los diseñadores están utilizando cada vez más alternativas que ofrecen ventajas en el embalaje, en los costos, en el consumo de energía, en la reducción de datos y en el rendimiento general. Entre las alternativas se encuentran los sistemas de imagen en tiempo de vuelo (TOF, también conocido como Detector de luz y su alcance [LIDAR]). Estas se pueden complementar con imágenes infrarrojas (IR), también conocidas como termografía.

Comenzar con IR

Las ondas electromagnéticas rojas cuentan con una longitud de onda más grande que aquellas en el extremo rojo del espectro visible; la longitud de las ondas de la banda IR por lo general va de 700 nm (0,7 μm) a 1 mm (1000 μm). En términos sencillos, representan el calor irradiado de un objeto. Con un sistema apropiado de imágenes IR, este “mapa de calor” IR se transforma en una imagen de luz visible, a veces con un color falso agregado para resaltar las temperaturas relativas (Figura 1).

Figura 1: una imagen infrarroja de agua que cae de un tubo a una tina; note cómo el “color falso” se utiliza para transmitir mejor las diferencias en temperatura. (Imagen cortesía de FLIR Systems, Inc.)

Note que lasimágenes IR no son lo mismo que la detección de IR. La detección es un método de no contacto utilizado para localizar e incluso medir una fuente de calor, como una persona que pasa por enfrente de un sensor infrarrojo pasivo (PIR) como parte de un sistema de alarma o se controla el calor excesivo desde un tubo; no existe una resolución de imágenes o detalles similares a los de una imagen.

¿Por qué utilizar imágenes IR en lugar de o además de las imágenes de luz visible convencionales? Existen numerosas razones:

- IR es importante cuando los objetos que nos interesan se confunden con el fondo, ya sea un por ocultamiento intencionado o solamente una coincidencia.

- IR puede ayudar a ubicar a personas o animales de sangre caliente presentes en el campo de visión.

- IR también es útil cuando se busca una falla, como un tubo o una barrera de vapor recalentada, un fuego incandescente o una falla eléctrica, que pueden causar calor localizado.

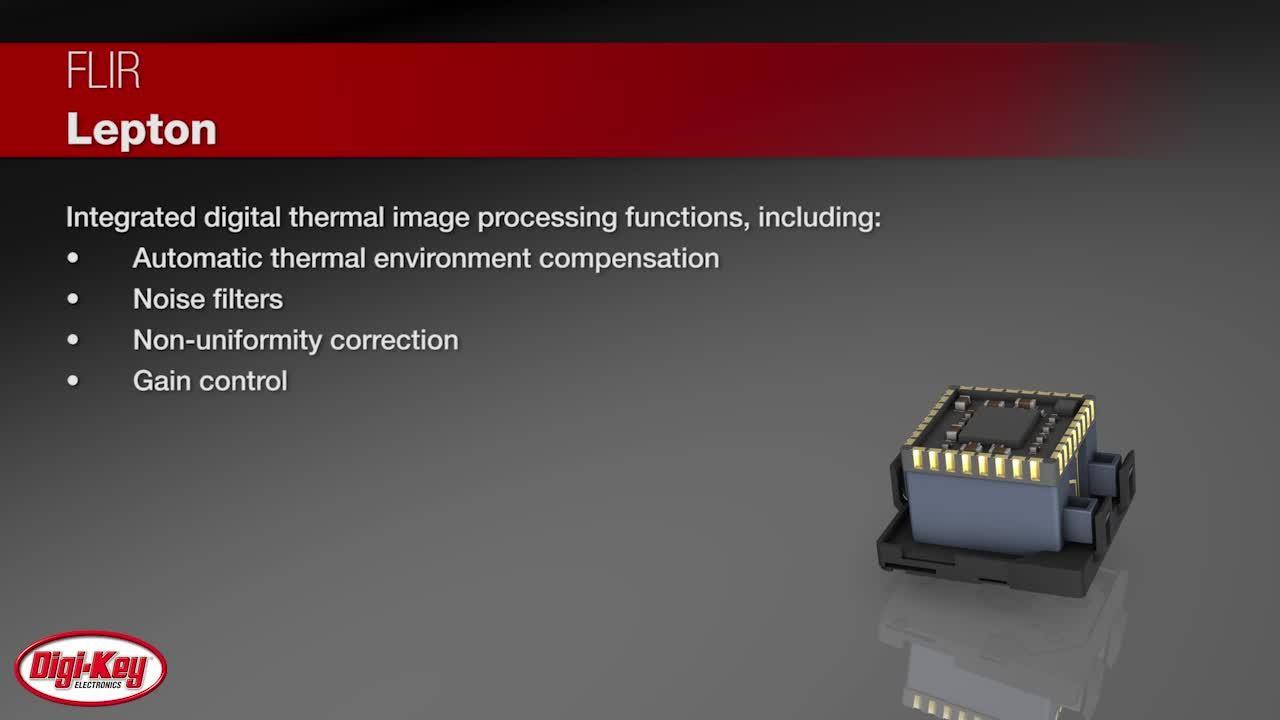

Implementar el subsistema de imágenes IR en la actualidad se simplifica dado a los componentes de alto rendimiento integrados con interfaces fáciles de utilizar. Tome como ejemplo la cámara IR Lepton de FLIR Systems, Inc., (Figura 2). Cuenta aproximadamente con 10 × 12 × 6 mm de profundidad, incorpora un montaje de lente con foco, un conjunto de sensores con onda infrarroja de 80 × 60 píxeles de largo (LWIR) de 8 hasta 14 μm IR y electrónicos procesadores de señal.

Figura 2: El productor de imágenes FLIR Lepton (que se muestra sin toma) es una unidad altamente integrada que incluye características procesadoras de imágenes y programables por el usuario. (Imagen cortesía de FLIR Systems, Inc.)

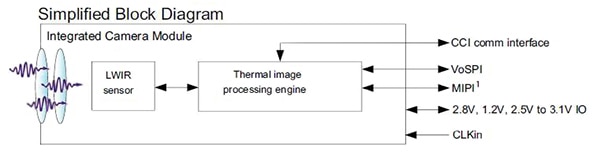

La interconexión se simplifica mediante la utilización de interfaces de video MIPI y SPI de estándar industrial y la interfaz de cable doble serial para controlar, que es similar a la I2C (Figura 3). A pesar de su pequeño tamaño y de su facilidad de uso, la unidad Lepton presenta un alto rendimiento, con un tiempo rápido de captura de imagen por debajo de los 0,5 s y una sensibilidad térmica de menos de 50 mK. La potencia operativa también es baja, de 150 mW (por lo general).

Figura 3: Este simplificado diagrama de bloques de la unidad Lepton muestra su unidad integral de procesamiento de imagen además de la matriz básica de sensores, como así también su simple interfaz al sistema del usuario. (Imagen cortesía de FLIR Systems, Inc.)

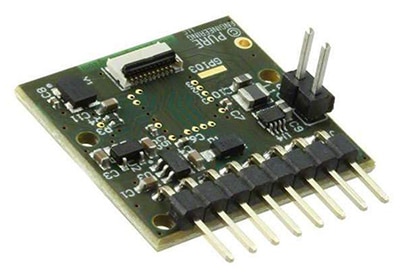

Los productos como este se benefician de la experiencia práctica del usuario; es por eso que FLIR ofrece una placa de interfaz para el módulo de la cámara que es compatible con las placas de evaluación basadas en ARM y Raspberry Pi (Figura 4). Esta placa de 25 mm × 24 mm requiere un suministro único de 3 V a 5,5 V e incluye un reloj de sistema de 25 MHz, LDO internos para proporcionar rieles de energía adicionales para bajo ruido y cabeceras interconectadas de manera estándar, como así también una cabecera Molex de 32 clavijas para el módulo Lepton.

(a)

(b)

Figura 4: La placa de interfaz Lepton (a) (mostrada sin la unidad Lepton) les permite a los diseñadores evaluar y programar la unidad a la vez que usan placas de evaluación debido a su conexión e interfaz estándares (b). (Imágenes cortesía de FLIR Systems, Inc.)

El TOF toma vuelo

Para numerosas aplicaciones, la imagen térmica es útil pero insuficiente, y se requiere un sistema de imagen, a veces en 3D. La solución obvia consiste en obtener una cámara de video estándar, dado que estas ahora están disponibles de parte de decenas de proveedores en numerosas resoluciones, sensibilidades a la luz, tamaños y opciones de interfaz. Si se requieren imágenes acústicas, utilice un par.

A diferencia de la termografía que ha estado disponible durante décadas pero con un rendimiento más rudimentario, a un costo más alto y con disipación de potencia más alta que las unidades de la actualidad, el TOF es relativamente nuevo. Primero se lo propuso como un concepto académico en la década del noventa; sin embargo, los componentes necesarios y las capacidades de procesamiento que lo hacen práctico comenzaron a estar disponibles en el último decenio.

TOF por lo general es el enfoque preferido a las imágenes por numerosas aplicaciones, incluidos los vehículos autónomos (coches sin conductor) y se lo ha probado literalmente en la ruta durante millones de kilómetros. (En términos arquitectónicos, un vehículo autónomo inteligente es un tipo de sistema robótico especializado sobre ruedas, con sensores, algoritmos y acciones definidas; solamente se trata de una cuestión de perspectiva). El enfoque del TOF en realidad cuenta con algunas ventajas distintas en comparación con la cámara de imágenes tradicional (se discute más abajo).

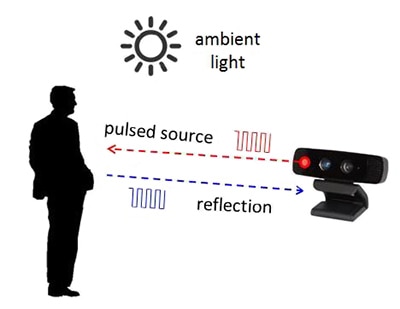

Cómo funciona: a diferencia de las imágenes de una cámara convencional, en la que los principios operativos por lo general son entendidos por los ingenieros y son algo intuitivos, el TOF se conoce menos y depende tanto de las ecuaciones como de los fotones sensibles para su implementación. Sus dos componentes principales son precisamente una fuente de energía controlada y modulada, que es un láser en estado sólido o bien un led (que por lo general opera en 850 μm cerca del alcance de la IR y, por lo tanto, invisible al ojo humano), y una matriz de píxeles para “ver” los reflejos de luz emitidos desde la escena de la que se está captando la imagen (Figura 5).

Figura 5: el concepto de alto nivel de TOF es simple: proyecte una luz pulsada en la escena y capture los pulsos de luz reflejados y su tiempo; la implementación real es mucho más compleja, pero es práctica. (Imagen cortesía de Texas Instruments)

Para comprender del todo el principio del TOF, se requiere de ecuaciones que definen sus operaciones y también conducen a representar algunas de las fuentes de error inevitables para luego compensarlas. El proceso general del TOF se puede realizar de dos maneras: la fuente de luz es pulsada repetidamente en un ciclo de trabajo bajo o se modula a través de un seno continuo o una fuente de onda cuadrada. Si se utiliza el modo de pulsado, la energía de luz reflejada se muestra mediante la utilización de dos ventanas fuera de fase y luego estas muestras se utilizan para computar la distancia del objetivo. Si se utiliza el modo continuo, el sensor toma cuatro muestras por medición con un offset de 90° para cada muestra, y se puede calcular el ángulo de la fase frente a la iluminación y el reflejo (y así la distancia).

El resultado de una secuencia y de los cálculos del TOF es una nube de puntos que representan las áreas representadas por la imagen; por eso el término “nube de puntos”.[1]

Ventajas y desventajas relativas: decidir entre una o dos imágenes convencionales y un enfoque TOF incluye compensaciones que se centran en los detalles de la aplicación. Para realizar una inspección y un reconocimiento de defectos básicos, donde el objeto se conoce de antemano y el objetivo es presentar extracción/comparación dentro de un entorno iluminado controlado, una sola cámara que ofrezca imagen en 2D es la mejor opción. Sin embargo, si la iluminación varía, el TOF puede ser mejor, dado que lo afectan menos las variaciones ambientales de luz.

Para las imágenes en 3D que utilizan dos cámaras convencionales, la decisión presenta más dimensiones que comienzan con cuestiones mecánicas y de montaje. Incluso si estos no son problemas, el sistema que procesa la imagen debe contar con algoritmos robustos para solucionar el problema de “correspondencia” de unir un punto en la escena de una cámara con el mismo punto en la escena de la segunda cámara. Hacer eso requiere una cantidad significativa de color o variación en la escala de grises; y, a veces, la precisión de profundidad se limita debido a la superficie uniforme de la escena de la que se proyecta una imagen. En cambio, el sistema TOF se ve menos afectado por las cuestiones mecánicas, de iluminación y de contraste, y no requiere una unión de correspondencia de la imagen para lograr un resultado en 3D.

Debido a su rápido tiempo y habilidad de respuesta para lidiar con alcances extensos en las características de los sujetos, como así también la naturaleza de la nube de puntos que genera, los sistemas TOF son ideales para traducir gestos realizados con las manos, el rosto o el cuerpo en comandos, como así también capturar los alrededores en vehículos autónomos. Sin embargo, las soluciones que utilizan las configuraciones de una o dos cámaras convencionales son menos costosas, dada la gran disponibilidad de muchas de las cámaras básicas de imágenes.

Implementación: un sistema TOF cuenta con cinco bloques funcionales principales:

- Fuente de luz: un componente para generar pulsos de luz programados cuidadosamente.

- Óptica: una lente para enfocar la luz en el sensor; seguramente contará con un filtro de banda pasante óptico para reducir el “ruido” de luz ambiental.

- Sensor de imagen: captura los reflejos de la luz emitida de la escena iluminada.

- Gestión electrónica: controla y sincroniza la unidad de iluminación y el sensor de imágenes.

- Unidad informática e interfaz: calcula la distancia según el tiempo de iluminación frente a los fotones devueltos y sensibles.

Seleccionar el emisor de luz y el sensor de imagen son los primeros pasos para la configuración del sistema TOF. Una elección de emisor es un diodo como Vishay VSMY1850X01, un dispositivo IR de 850 μm diseñado para operar a alta velocidad. Soporta hasta 10 ns de tiempo de subida y caída cuando se lo controla con 100 mA; esto hace que sea ideal para el modo pulsado.

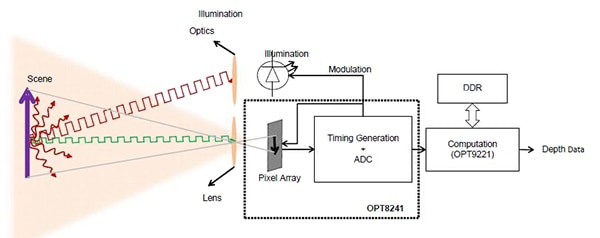

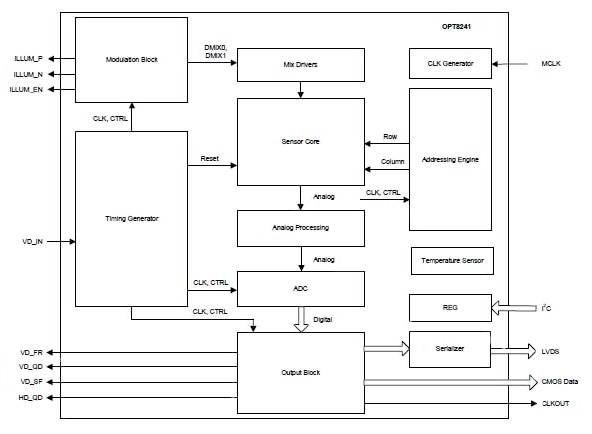

El sensor o la matriz de píxeles constituye el centro del sistema TOF y actualmente se encuentra disponible como parte de un dispositivo más grande e integrado como el controlador/sensor de tiempo de vuelo IC OPT8241 de Texas Instruments (Figura 6). Contiene la fuente del sensor (elemento 3 de arriba) y electrónicos de control (elemento 4), como se ve en diagrama de bloque simplificado (Figura 7), y ofrece un reflejo digitalizado de los datos en un procesador como el Controlador de tiempo de vuelo OPT9221,que computa los datos de profundidad del sensor de datos digitalizado. El OPT9221 también implementa numerosas funciones de corrección, incluidas antialias, compensación por no linealidad y compensación de temperatura.

Figura 6: Al utilizar el OPT8241 de TI junto con el motor informático de OPT9221; los diseñadores pueden crear un sistema TOF con esfuerzos modestos de hardware y con relativamente pocos componentes.

Figura 7: El diagrama de bloque interno simplificado de OPT8241 muestra algunas de las complejidades que utiliza para implementar el Front End del TOF; incluye el control de modulación y el controlador para la iluminación de led. (Imagen cortesía de Texas Instruments)

Como sucede con cualquier sistema de video diseñado no solamente para capturar una escena, sino también para hacerlo de manera consistente y útil, el diseño del software del TOF no es trivial. TI ofrece una guía del usuario detallada[2] y una herramienta estimadora que les permite a los diseñadores evaluar el rendimiento y la interacción de los parámetros, como la resolución de profundidad, la resolución 2D (número de píxeles), el alcance de la distancia, la velocidad de imagen, el campo de visión (FOV), la luz ambiente y la reflectividad del objeto.

Conclusión

Siempre se desafió a los diseñadores de los sistemas robóticos a que brindaran maneras de proporcionar un “sentido de los alrededores” detallado. Afortunadamente, los diseñadores actuales tienen acceso a tecnologías de alto rendimiento, potentes y de costo relativamente bajo, incluidas las imágenes infrarrojas, las cámaras de video convencionales e incluso el LIDAR basado en los principios de tiempo de vuelo. Como resultado, y debido al consumo generalmente bajo de energía, numerosos diseños completos utilizan una combinación de estos enfoques para solucionar las fallas de cualquier técnica única y para así brindar una imagen multidimensional más completa.

Referencias:

- “Cámara tiempo de vuelo: introducción", Texas Instruments

- “Introducción al diseño de sistema de tiempo de vuelo (TOF),", Texas Instruments

Descargo de responsabilidad: Las opiniones, creencias y puntos de vista expresados por los autores o participantes del foro de este sitio web no reflejan necesariamente las opiniones, las creencias y los puntos de vista de DigiKey o de las políticas oficiales de DigiKey.