Cómo optimizar la logística interna para agilizar y acelerar las cadenas de suministro de la Industria 4.0 - Segunda parte de dos

Colaboración de Editores de DigiKey de América del Norte

2023-09-22

La Parte 1 de esta serie sobre intralogística trata temas relacionados con el modo en que los robots móviles autónomos (AMR) y los vehículos de guiado automático (AGV) se utilizan a nivel de sistema para implantar la intralogística y trasladar materiales de forma rápida y segura según sea necesario. Este artículo se centra en los casos de uso y en cómo los AMR y los AGV emplean sensores para identificar y rastrear artículos, cómo el aprendizaje automático (ML) y la inteligencia artificial (AI) apoyan la identificación de materiales, el movimiento y la entrega de materiales en todo el almacén y las instalaciones de producción.

La intralogística (logística interna) utiliza robots móviles autónomos (AMR) y vehículos de guiado automático (AGV) para mover materiales de forma eficiente por los almacenes y las instalaciones de producción de la Industria 4.0. Para racionalizar y agilizar las cadenas de suministro, los sistemas intralogísticos necesitan conocer la ubicación actual del material, el destino previsto del mismo y la ruta más segura y eficiente para que el material llegue a su destino. Esta navegación ágil requiere una diversidad de sensores.

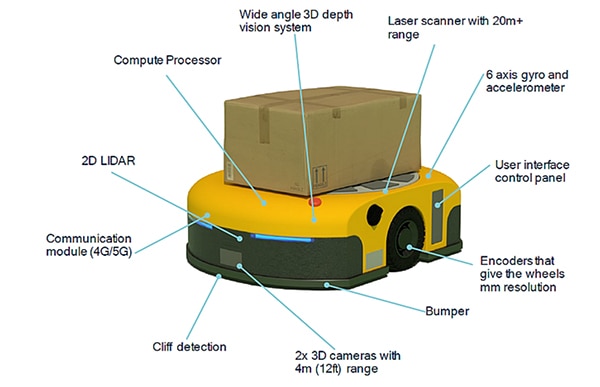

En las soluciones intralogísticas, los AGV y AMR utilizan sensores para aumentar su conocimiento de la situación. Las matrices de sensores proporcionan seguridad al personal cercano, protección a otros equipos y una navegación y localización eficaces. En función de los requisitos de la aplicación, las tecnologías de sensores para AMR pueden incluir sensores de contacto, como interruptores de fin de carrera integrados en los parachoques, detección y localización de luz 2D y 3D (LiDAR), ultrasonidos, cámaras 2D y estéreo, radar, codificadores, unidades de medición inercial (IMU) y fotocélulas. En el caso de los AGV, los sensores pueden ser magnéticos, inductivos u ópticos, así como interruptores de fin de carrera integrados en los parachoques, LiDAR 2D y codificadores.

El primer artículo de esta serie aborda cuestiones relacionadas con el modo en que los AMR y los AGV se utilizan a nivel de sistema para implantar la intralogística y trasladar eficazmente los materiales según sea necesario.

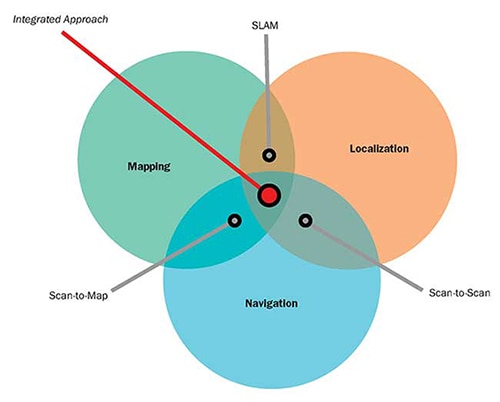

Este artículo se centra en la fusión de sensores y en cómo los AMR y los AGV emplean combinaciones de sensores más IA y ML para la localización, la navegación y la seguridad operativa. Comienza con un breve repaso de los sensores más comunes en los vehículos autoguiados, examina la postura del robot y los algoritmos de localización y mapeo simultáneos (SLAM) mediante la fusión de sensores, estudia cómo pueden mejorarse las estimaciones SLAM con técnicas de correspondencia de escaneado a mapa y de escaneado a escaneado, y concluye con un repaso de cómo la fusión de sensores contribuye al funcionamiento seguro de los AMR y los vehículos autoguiados. DigiKey apoya a los diseñadores con un amplio rango de sensores e interruptores para robótica y otras aplicaciones industriales en todos estos casos.

Se necesita una gama de sensores y fusión de sensores, IA, ML y conectividad inalámbrica para apoyar el funcionamiento autónomo y la seguridad en los AMR. Aunque las exigencias de rendimiento de los AGV son menores, siguen dependiendo de múltiples sensores para garantizar un funcionamiento seguro y eficaz. Hay dos categorías principales de sensores:

- Los sensores propioceptivos miden valores internos del robot como la velocidad de las ruedas, la carga, la carga de la batería, etc.

- Los sensores exteroceptivos proporcionan información sobre el entorno del robot, como mediciones de distancia, localización de puntos de referencia e identificación de obstáculos, como personas que se cruzan en el camino del robot.

La fusión de sensores en AGV y AMR se basa en combinaciones de sensores propioceptivos y exteroceptivos. Algunos ejemplos de sensores en AMR son (Figura 1):

- Escáner láser para detección de objetos con alcance de más de 20 metros (m)

- IMU con giroscopio de 6 ejes y acelerómetro, y a veces con magnetómetro.

- Codificadores con resolución milimétrica (mm) en las ruedas

- Sensor de contacto como un microinterruptor en el parachoques para detener inmediatamente el movimiento si se entra en contacto con un objeto inesperado.

- Dos cámaras 3D orientadas hacia delante con un alcance de 4 m

- Sensor orientado hacia abajo para detectar el borde de una plataforma (denominado detección de acantilados)

- Módulos de comunicaciones para proporcionar conectividad y, opcionalmente, pueden ofrecer detección Bluetooth del ángulo de llegada (AoA) y del ángulo de salida (AoD) para servicios de localización en tiempo real (RTLS) o puntos de transmisión/recepción (TRP) 5G para trazar una cuadrícula con precisión centimétrica.

- LiDAR 2D para calcular la proximidad de obstáculos delante del vehículo

- Sistema de visión en profundidad 3D gran angular adecuado para la identificación y localización de objetos

- Procesador informático de alto rendimiento a bordo para fusión de sensores, IA y ML.

Figura 1: AMR ejemplar que muestra la diversidad y las posiciones de los sensores incorporados. (Fuente de la imagen: Qualcomm)

Figura 1: AMR ejemplar que muestra la diversidad y las posiciones de los sensores incorporados. (Fuente de la imagen: Qualcomm)

Postura del robot y fusión de sensores

La navegación AMR es un proceso complejo. Uno de los primeros pasos es que el AMR sepa dónde está y en qué dirección mira. Esa combinación de datos se denomina pose del robot. El concepto de pose también puede aplicarse a los brazos y efectores finales de robots estacionarios multieje. La fusión de sensores combina las entradas de la IMU, los codificadores y otros sensores para determinar la pose. El algoritmo de pose estima la posición (x, y) del robot y el ángulo de orientación θ, con respecto a los ejes de coordenadas. La función q = (x, y, θ) define la pose del robot. En el caso de las AMR, la información sobre poses tiene diversos usos:

- La pose de un intruso, como una persona que entra cerca del robot, con respecto a un marco de referencia externo o con respecto al robot.

- La pose estimada del robot tras moverse a una velocidad determinada durante un tiempo predeterminado.

- Cálculo del perfil de velocidad necesario para que el robot pase de la pose actual a una segunda pose.

Pose es una función predefinida en varios entornos de desarrollo de software para robots. Por ejemplo, el paquete robot_pose_ekf está incluido en Robot Operating System (ROS), una plataforma de desarrollo de código abierto. Robot_pose_ekf puede utilizarse para estimar la pose 3D de un robot basándose en mediciones de pose (parciales) de varios sensores. Utiliza un filtro de Kalman ampliado con un modelo 6D (posición 3D y orientación 3D) para combinar las mediciones del codificador para la odometría de las ruedas, una cámara para la odometría visual y la IMU. Dado que los distintos sensores funcionan con velocidades y latencias diferentes, robot_pose_ekf no requiere que todos los datos de los sensores estén disponibles de forma continua o simultánea. Cada sensor se utiliza para proporcionar una estimación de la pose con una covarianza. Robot_pose-ekf identifica la información disponible de los sensores en cualquier momento y se ajusta en consecuencia.

Fusión de sensores y SLAM

Muchos entornos en los que operan los AMR incluyen obstáculos variables que pueden moverse de vez en cuando. Aunque un mapa básico de las instalaciones es útil, se necesita más. Cuando se desplazan por una instalación industrial, los AMR necesitan algo más que información de pose; también emplean SLAM para garantizar un funcionamiento eficaz. SLAM añade la cartografía del entorno en tiempo real para facilitar la navegación. Existen dos enfoques básicos del SLAM:

- SLAM visual que combina una cámara con una IMU

- LiDAR SLAM que combina un sensor láser como LiDAR 2D o 3D con una IMU

El SLAM LiDAR puede ser más preciso que el SLAM visual, pero suele ser más caro de implementar. Alternativamente, la 5G puede utilizarse para proporcionar información de localización que mejore las estimaciones visuales SLAM. El uso de redes 5G privadas en almacenes y fábricas puede aumentar los sensores integrados para SLAM. Algunos AMR implementan el posicionamiento preciso en interiores utilizando puntos de transmisión/recepción (TRP) 5G para trazar una cuadrícula con una precisión de centímetros en los ejes x, y y z.

El éxito de la navegación depende de la capacidad del AMR para adaptarse a los elementos cambiantes del entorno. La navegación combina SLAM visual y/o SLAM LiDAR, tecnologías de plantilla como 5G TRP y ML para detectar cambios en el entorno y proporcionar actualizaciones constantes de la ubicación. La fusión de sensores ayuda al SLAM de varias maneras:

- Actualizaciones continuas del modelo espacial y semántico del entorno basadas en las entradas de varios sensores mediante IA y ML.

- Identificación de obstáculos, lo que permite a los algoritmos de planificación de trayectorias realizar los ajustes necesarios y encontrar la trayectoria más eficiente a través del entorno.

- Ejecución del plan de trayectoria, que requiere un control en tiempo real para modificar la trayectoria prevista, incluidas la velocidad y la dirección del AMR, a medida que cambia el entorno.

Cuando SLAM no es suficiente

El SLAM es una herramienta vital para una navegación AMR eficaz, pero por sí solo es insuficiente. Al igual que los algoritmos de pose, el SLAM se implementa con un filtro de Kalman ampliado que proporciona valores estimados. Los valores estimados de SLAM amplían los datos de pose, añadiendo velocidades lineales y rotacionales y aceleraciones lineales, entre otros. La estimación SLAM es un proceso de dos pasos; el paso inicial consiste en compilar predicciones utilizando análisis de sensores internos basados en las leyes físicas del movimiento. El paso restante en la estimación SLAM requiere lecturas de sensores externos para refinar las estimaciones iniciales. Este proceso en dos pasos ayuda a eliminar y corregir pequeños errores que pueden acumularse con el tiempo y crear errores significativos.

El SLAM depende de la disponibilidad de entradas de sensores. En algunos casos, el LiDAR 2D de costo relativamente bajo puede no funcionar, por ejemplo si no hay objetos en la línea de visión directa del sensor. En esos casos, las cámaras estereoscópicas 3D o el LiDAR 3D pueden mejorar el rendimiento del sistema. Sin embargo, las cámaras estereoscópicas 3D o los LiDAR 3D son más caros y requieren más potencia de cálculo para su implementación.

Otra alternativa es utilizar un sistema de navegación que integre SLAM con técnicas de correspondencia de escaneado a mapa y de escaneado a escaneado que puedan implementarse utilizando solo sensores LiDAR 2D (Figura 2):

- El cotejo de escáner a mapa utiliza datos de alcance LiDAR para estimar la posición del AMR cotejando las mediciones de alcance con un mapa almacenado. La eficacia de este método depende de la precisión del mapa. No experimenta deriva con el tiempo, pero en entornos repetitivos puede dar lugar a errores difíciles de identificar, provocar cambios discontinuos en la posición percibida y ser difícil de eliminar.

- La correspondencia entre exploraciones utiliza datos LiDAR secuenciales para estimar la posición de un AMR entre exploraciones. Este método proporciona información actualizada sobre la ubicación y la pose del AMR independientemente de cualquier mapa existente y puede ser útil durante la creación de mapas. Sin embargo, se trata de un algoritmo incremental que puede sufrir desviaciones con el paso del tiempo sin que sea posible identificar las imprecisiones que dichas desviaciones introducen.

Figura 2: Los algoritmos de correspondencia de barrido a mapa y de barrido a barrido pueden utilizarse para complementar y mejorar el rendimiento de los sistemas SLAM. (Fuente de la imagen: Aethon)

Figura 2: Los algoritmos de correspondencia de barrido a mapa y de barrido a barrido pueden utilizarse para complementar y mejorar el rendimiento de los sistemas SLAM. (Fuente de la imagen: Aethon)

La seguridad requiere la fusión de sensores

La seguridad es una preocupación clave para los AGV y los AMR, por lo que deben tenerse en cuenta varias normas. Por ejemplo, American National Standards Institute / Industrial Truck Standards Development Foundation (ANSI/ITSDF) B56.5 - 2019, Safety Standard for Driverless, Automatic Guided Industrial Vehicles and Automated Functions of Manned Industrial Vehicles, la ANSI / Robotic Industrial Association (RIA) R15.08-1-2020 - Standard for Industrial Mobile Robots - Safety Requirements, varias normas de la Organización Internacional de Normalización (ISO), y otras.

El funcionamiento seguro de los AGV y AMR requiere una fusión de sensores que combine sensores LiDAR 2D con certificación de seguridad (a veces denominados escáneres láser de seguridad) con codificadores en las ruedas. El LiDAR 2D admite simultáneamente dos distancias de detección, puede tener un ángulo de detección de 270° y se coordina con la velocidad del vehículo notificada por los codificadores. Cuando se detecta un objeto en la zona de detección más alejada (hasta 20 m de distancia, según el sensor), el vehículo puede reducir la velocidad según sea necesario. Si el objeto entra en la zona de detección más cercana en la línea de desplazamiento, el vehículo detiene su marcha.

Los escáneres láser de seguridad suelen utilizarse en juegos de 4, colocando uno en cada esquina del vehículo. Pueden funcionar como una sola unidad y comunicarse directamente con el controlador de seguridad del vehículo. Los escáneres están disponibles y certificados para su uso en aplicaciones de categoría de seguridad 3, nivel de rendimiento d (PLd) y nivel de integridad de seguridad 2 (SIL2), y están alojados en un receptáculo IP65 adecuado para la mayoría de las aplicaciones de exterior e interior (Figura 3). Los escáneres incluyen una entrada para la información del codificador incremental de las ruedas para apoyar la fusión de sensores.

Figura 3: Sensores lidar 2D como éste pueden combinarse con codificadores en las ruedas en un sistema de fusión de sensores que proporciona un funcionamiento seguro de los AMR y los AGV. (Fuente de la imagen: Idec)

Figura 3: Sensores lidar 2D como éste pueden combinarse con codificadores en las ruedas en un sistema de fusión de sensores que proporciona un funcionamiento seguro de los AMR y los AGV. (Fuente de la imagen: Idec)

Conclusión:

La intralogística favorece cadenas de suministro más rápidas y eficientes en almacenes y fábricas de la Industria 4.0. Los AMR y los AGV son herramientas importantes de la intralogística para trasladar material de un lugar a otro de forma puntual y segura. La fusión de sensores es necesaria para apoyar las funciones AMR y AGV, incluida la determinación de la postura, el cálculo de los datos SLAM, la mejora del rendimiento de la navegación mediante la correspondencia de escaneado a mapa y de escaneado a escaneado, y la garantía de seguridad para el personal y los objetos en toda la instalación.

Descargo de responsabilidad: Las opiniones, creencias y puntos de vista expresados por los autores o participantes del foro de este sitio web no reflejan necesariamente las opiniones, las creencias y los puntos de vista de DigiKey o de las políticas oficiales de DigiKey.